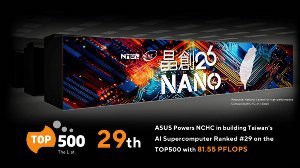

ASUS e NCHC realizzano il Supercomputer AI più Potente di Taiwan

ASUS, in collaborazione con il National Center for High-performance Computing (NCHC) di Taiwan, ha realizzato un nuovo supercomputer AI, che ora è pienamente operativo. Basato su un'architettura ibrida che include il cluster Nano4 NVIDIA® HGX H200 e il recente sistema NVIDIA GB200 NVL72, il nuovo supercomputer AI è il primo a Taiwan con queste caratteristiche a essere completamente raffreddato a liquido. In grado di offrire fino a 81,55 PFLOPS, si colloca al 29° posto nella classifica TOP500, segnando una tappa fondamentale nel rafforzamento delle capacità di calcolo AI di Taiwan e nell'accelerazione della sua “intelligent transformation”.

Il portavoce dell'NCHC, il Dr. Chia-Lee Yang, ha dichiarato: “In qualità di designer del Nano4, l'NCHC ha delineato l'architettura, la strategia di raffreddamento a liquido e l'integrazione del sistema. Grazie all'esperienza di ASUS nell'infrastruttura AI, questo sistema di nuova generazione è in grado di fornire la potenza necessaria per l'AI generativa, i big data, il deep learning e l'HPC, fornendo capacità di calcolo senza precedenti sia per il mondo accademico, sia per l'industria”.

Leggi anche ASUS - disponibile il supercomputer AI compatto Ascent GX10

Architettura innovativa e sistema di raffreddamento a liquido

Questo supercomputer AI utilizza su due soluzioni di elaborazione complementari. La prima si basa sul sistema ESC NM2N721-E1 progettato da ASUS ed equipaggiato con l’architettura NVIDIA GB200 NVL72, dove ogni rack integra 36 CPU NVIDIA Grace e 72 GPU con tecnologia NVIDIA Blackwell. La seconda soluzione di elaborazione comprende un cluster di server ASUS ad alte prestazioni pensati per garantire flessibilità e scalabilità, tra cui i server ESC N8-E11V equipaggiati con schede NVIDIA HGX H200 e raffreddamento a liquido Direct-to-Chip (D2C), oltre ai server ESC8000-E12 equipaggiati con GPU NVIDIA MXH200, compatibili con il sistema di interconnessione NVIDIA NVLink Bridge, ideali per gestire carichi di lavoro AI particolarmente complessi.

Realizzato da zero da ASUS, questo supercomputer AI sfrutta la tecnologia di raffreddamento a liquido diretto (DLC), che raggiunge un valore di efficienza PUE (Power Usage Effectivness) di appena 1,18, grazie ad una combinazione ottimale fra prestazioni elevate, efficienza energetica e design sostenibile, a riprova della competenza di ASUS nell’innovare ed implementare soluzioni all’avanguardia nella gestione energetica dei datacenter e supercomputer.

Un supercomputer AI basato su infrastruttura ASUS AI ad implementazione rapida

Uno storage affidabile e scalabile è essenziale per i supercomputer che devono essere in grado di gestire carichi di lavoro AI particolarmente pesanti. ASUS sfrutta i server di storage OJ340A-RS60 e RS501A-E12-RS12U, che supportano lo storage di file, oggetti e blocchi con configurazioni all-flash, tiered e di backup per applicazioni AI e HPC.

Per accelerare ulteriormente l'implementazione, la multinazionale taiwanese ha sviluppato ASUS Infrastructure Deployment Center (AIDC), una soluzione di automazione che semplifica la configurazione e la gestione dei cluster HPC, riducendo i tempi di implementazione da tre settimane a tre giorni e garantendo al contempo massime prestazioni, scalabilità e affidabilità, mentre ASUS Professional Services copre le attività di validazione, integrazione e ottimizzazione dei sistemi di archiviazione, raffreddamento a liquido e di rete, consentendo alle organizzazioni di scalare le infrastrutture AI in modo efficiente, sostenibile e affidabile.

ASUS: un partner esperto nel campo del supercalcolo AI

Con decenni di esperienza nel settore dei server, ASUS è in grado di fornire infrastrutture AI end-to-end che comprendono server, storage, edge e software. Grazie a un ampio bagaglio di competenze, alle possibilità di personalizzazione e alla comprovata esperienza nell’ambito delle implementazioni, ASUS consente alle aziende di scalare l'AI in modo efficiente, forte di oltre 1.900 record mondiali SPEC CPU e oltre 230 record mondiali MLPerf.